On reprochait à Meta d’être en retrait face à OpenAI, Google ou Mistral dans la course à l’IA. Mais son équipe FAIR (Fundamental AI Research) vient de frapper un grand coup avec TRIBE : un réseau neuronal profond de 1 milliard de paramètres capable de prédire comment le cerveau humain réagit à un film… sans même avoir besoin d’un scanner cérébral.

Résultat : 1ʳᵉ place au concours international de modélisation cérébrale Algonauts 2025, avec une avance nette sur tous les c

TRIBE est le premier modèle d’IA spécifiquement entraîné à prédire les réponses du cerveau humain à divers stimuli.

TRIBE est une avancée majeure pour la modélisation de la cognition humaine assistée par intelligence artificielle. C’est le premier réseau neuronal profond à intégrer texte, audio et vidéo pour la prédiction fine des réponses cérébrales à l’échelle du cerveau entier et sur de longs enregistrements, ouvrant la voie à une compréhension plus unifiée de la représentation multimodale dans le cerveau

🎬 Comment ça marche ?

TRIBE analyse la vidéo, l’audio et les dialogues d’un film pour prédire quelles régions du cerveau du spectateur vont s’activer.

Formé sur 80 heures de télévision et de films, il a correctement anticipé plus de la moitié des modèles d’activité dans 1 000 régions cérébrales.

Ses performances sont 30 % supérieures aux modèles « monosensoriels » classiques, notamment dans les zones où vue, son et langage se combinent.

Bonus : TRIBE excelle aussi dans les régions frontales liées à l’attention, à la prise de décision et aux émotions.

TRIBE (TRImodal Brain Encoder) est le premier réseau de neurones profond explicitement conçu pour prédire la réponse cérébrale mesurée par IRMf (imagerie par résonance magnétique fonctionnelle) à des vidéos, en s’appuyant simultanément sur trois modalités : le texte, l’audio et la vidéo.

Fonctionnement et innovation :

- Fusion multimodale : TRIBE combine les représentations pré-entraînées de trois modèles fondationnels de Meta :

- Texte : Llama 3.2

- Audio : Wav2Vec2-BERT (Seamless)

- Vidéo : V-JEPA 2

- Traitement temporel : il utilise un transformeur pour intégrer l’évolution temporelle de ces signaux, capturant ainsi la dynamique fine de l’activité neuronale pendant la perception audiovisuelle d’un film.

- Prédiction des réponses cérébrales : le modèle est capable de prédire avec précision l’intensité et la localisation de l’activation dans le cerveau (spatio-temporelle) lors du visionnage de vidéos.

❓ Mais à quoi ça sert ?

- Recherche neuroscientifique : permet de rapprocher intelligence artificielle et neurosciences, en fournissant un modèle opérationnel pour l’intégration cerveau-multimodalité.

- Code open source & données : le modèle et les outils associés sont disponibles publiquement pour la communauté scientifique.

L’intérêt ne se limite pas à la recherche fondamentale en neurosciences. Ce type de modèle pourrait :

- Accélérer la compréhension du cerveau humain en liant des stimuli complexes (films, discussions, situations réelles) aux réponses neuronales, à grande échelle.

- Aider la médecine dans le diagnostic et la rééducation après AVC ou troubles cognitifs, en simulant comment un patient réagit à certains stimuli.

- Optimiser la création de contenus (cinéma, publicité, formation) en testant virtuellement leur impact sur l’attention et l’émotion du public… avant même de les produire.

- Mieux comprendre et potentiellement manipuler l’attention, ce qui ouvre autant de promesses que de débats éthiques — certains y voient déjà un outil qui pourrait rendre le doomscrolling encore plus addictif.

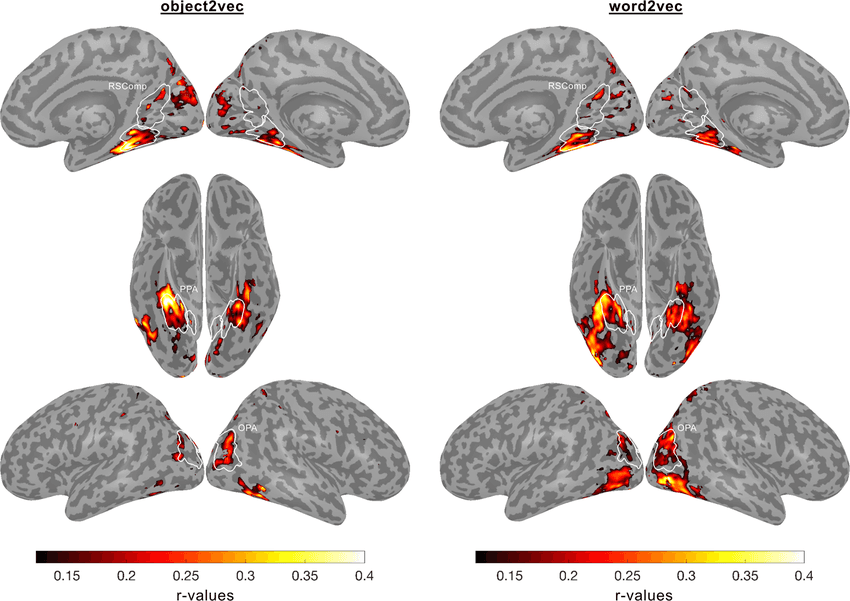

- Prédiction multimodale : contrairement aux modèles unimodaux (images ou sons seuls), TRIBE montre un avantage marqué dans la prédiction des activations des aires associatives de haut niveau, là où plusieurs modalités interagissent.

MetaAI #FAIR #TRIBE #Algonauts2025 #Neurosciences #BrainMapping #IRMf #MultimodalAI #DeepLearning #RechercheIA #InnovationIA #CerveauHumain #NeurosciencesCognitives #IAetScience #IAetSanté #MetaResearch #AI4Science #NeuroTech #AIResearch #IA

Références et liens associés :

- http://www.arxiv.org/abs/2507.22229

- https://chatpaper.com/zh-CN/chatpaper/paper/171941

- Téléchargez le code : https://lnkd.in/gmFRzFJQ

- En savoir plus sur le défi algonaute: https://lnkd.in/ga8fYeFt

- https://www.cneuromod.ca/

- https://www.researchgate.net/publication/394121496_TRIBE_TRImodal_Brain_Encoder_for_whole-brain_fMR